층을 깊게 하는 이유

층일 깊게 한 신경망은 깊지 않은 경우보다 적은 매개변수로 같거나 그 이상의 수준에 달하는 표현력을 달성할 수 있다.

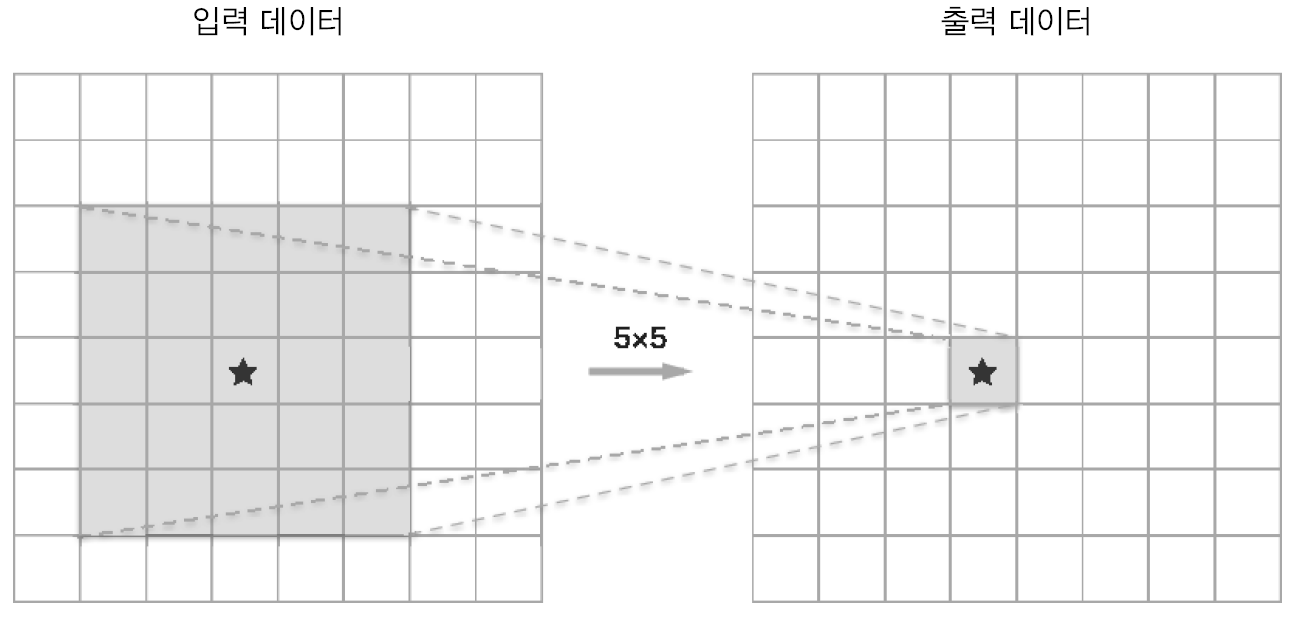

이 경우 필요한 매개변수를 5x5=25이다. 이러한 연산은 3x3 두 번으로 대체될 수 있다.

후자의 경우 매개변수가 2x3x3=18개이다.

이처럼 작은 필터를 겹쳐 신경망을 깊게 할 때의 장점은 매개변수 수를 줄여 넓은 수용영역을 소화할 수 있다. 그리고 층과 층 사이에 ReLU, BN 등을 끼움으로써 신경망의 표현력 또한 개선된다.

VGG

VGG는 합성곱 계층와 풀링 계층으로 구성되는 기본적인 CNN이다.

VGG에서 주목할 점은 3x3의 작은 필터를 사용한 합성곱 계층을 연속으로 거친다는 것이다.

GoogLeNet

GoogLeNet은 세로 방향만 깊을 뿐 아니라 가로 방향도 깊다는 점이 특징이다. 이 가로 방향의 구조를 인셉션이라 한다.

크기가 다른 필터과 풀링을 여러 개 적용하여 그 결과를 결합한다. 1x1 합성곱 계층은 채널 쪽으로 크기를 줄이는 것으로, 매개변수 제거와 고속 처리에 기여한다.

ResNet

ResNet은 skip connection을 통해 층을 깊게 할 시 생길 수 있는 문제점들을 보완하였다. 스킵 연결은 residual unit을 통해 이루어진다.

$f(x)$를 학습하는 것이 아닌 $f(x) + x$을 학습한다. 이는 gradient vanishing 문제를 막아준다.

'책 > 밑바닥부터 시작하는 딥러닝' 카테고리의 다른 글

| 7장 CNN (2) (0) | 2023.09.22 |

|---|---|

| 7장 CNN (1) (0) | 2023.09.21 |

| 6장 학습 관련 기술들 (2) (0) | 2023.09.20 |

| 6장 학습 관련 기술들 (1) (0) | 2023.09.20 |

| 5장 오차역전파법 (2) (0) | 2023.09.19 |